Il salto cognitivo di Google Gemini 3

Linee guida sull'evoluzione del prompt engineering per Google Gemini 3

L’arrivo di Gemini 3 Pro segna una transizione fondamentale per i professionisti della creatività e della ricerca.

Non siamo più di fronte a un semplice aggiornamento di capacità (più veloce, più contesto), ma a un cambio di paradigma nel “motore cognitivo” del modello. Se Gemini 2.5 era un eccellente previsore probabilistico di testo, Gemini 3 adotta un nuovo standard di “pensiero lento e deliberativo”.

Per scrittori, ricercatori e artisti, questo significa che le vecchie strategie di prompt engineering — spesso basate su trucchi per aggirare la pigrizia o le allucinazioni del modello — sono ora obsolete. Gemini 3 è progettato per essere nativamente meno compiacente e molto più diretto.

Addio al pappagallo

Fino a tre giorni fa, il prompt engineering assomigliava alla programmazione procedurale. Se volevi un risultato da Gemini 2.5, dovevi costruirgli una scala a pioli: “Fai A, poi se succede B, fai C”. Una specie di esercizio di logica, spesso snervante.

Con Google Gemini 3, la sintassi del comando passa in secondo piano rispetto alla semantica dell’intenzione. Non stiamo più scrivendo istruzioni per un esecutore cieco; stiamo dialogando con un sistema che riflette prima di parlare, grazie all’introduzione di Thinking Token (che non compromettono l’imbattibile valore globale della finestra contestuale che offre ancora un valore di 1.000.000 di token complessivi1).

Il cambiamento è radicale: Gemini 3 introduce il System 2 Thinking2, vale a dire che non “prevede” più la parola successiva (il pappagallo stocastico), ma pianifica il concetto intero. Può sembrare una sottigliezza, ma si tratta un cambiamento radicale.

Per anni (sì, sono già passati anni…), la nostra interazione con l’IA è stata una lotta contro la sua intrinseca pigrizia e la tendenza alla piaggeria (sycophancy). Scrivevamo prompt pieni di vincoli negativi: “Non usare la parola ‘sinfonia’, non essere prolisso, non allucinare” .

Con Gemini 3, queste strategie diventano obsolete. Il modello è stato addestrato per ridurre il cosiddetto “AI-ese” — quella prosa fiorita e vuota, tipicamente IA — privilegiando risposte “intelligenti, concise e dirette” .

Non toccare il volante

Evolvere la propria ingegnerizzazione di prompt per Gemini 3 richiede un atto di fede controintuitivo: bisogna smettere di guidare la macchina e “solo” definire con estrema precisione la destinazione finale e lo standard di qualità. E poi togliere le mani dal volante.

Per quanto ho potuto provare finora, le nuove formule richiedono una certa competenza nel campo in cui si pone la domanda, per generare risultati di qualità.

Gemini 3 comporta un “effetto specchio” potenziato: l’IA riflette la vostra immagine; se ciò che vedete non vi piace, dovete cambiare voi.

Ecco qualche esempio.

Ricerca Accademica (analisi dati)

Gemini 2.5

Agisci come un ricercatore esperto. Leggi i PDF allegati. Estrai i dati sulla crescita demografica del 1990-2020. Crea una tabella. Poi scrivi un riassunto di 200 parole evidenziando i trend principali. Non inventare dati.

Gemini 3

Obiettivo: isolare le anomalie demografiche nel dataset allegato (1990-2020). Thinking Process: prima di generare il report, analizza le correlazioni tra calo delle nascite e variabili economiche presenti nei documenti. Se trovi discrepanze nei dati, segnalale come ipotesi di errore nel thought stream. Output: sintesi critica delle anomalie.

Scrittura Accademica (articoli, saggi, tesi)

Gemini 2.5

Scrivi un saggio di 1000 parole sull’impatto dell’AI nella medicina. Usa questa struttura: Introduzione, Benefici, Rischi, Conclusione. Usa un tono formale. Cita 3 fonti reali.

Gemini 3

Tesi: L’AI in medicina sta spostando il focus dalla cura alla predizione, riducendo l’agency del medico. Constraint: Utilizza un approccio epistemologico foucaultiano. Antigravity Check: Verifica che ogni claim medico citato corrisponda a paper pubblicati su PubMed negli ultimi 24 mesi. Genera un saggio argomentativo che difenda questa tesi contro le obiezioni comuni.

Scrittura Creativa (narrativa)

Gemini 2.5

Scrivi una storia su un detective a Venezia. Piove. Lui è triste perché ha perso la moglie. Trova un indizio in una gondola. Finale a sorpresa.

Gemini 3

Contesto: Venezia, atmosfera neo-noir. Character Arc: Il protagonista sta vivendo la fase di negazione del lutto. Non menzionare mai esplicitamente la morte della moglie, ma fallo capire attraverso le sue interazioni sensoriali con l’ambiente (acqua, decadenza). Style: Prosa parattica, ritmo sincopato. Scrivi la scena del ritrovamento dell’indizio.

Generazione Immagini

Gemini 2.5

Foto realistica di un gatto vestito da astronauta su Marte. Luci al neon, stile cyberpunk, alta risoluzione, 4k.

Gemini 3

Soggetto: Felino in EVA suit. Composition: Regola dei terzi, focus sugli occhi. Lighting: Luce diegetica proveniente dal riflesso del casco. Antigravity Parameters: Rispetta la gravità ridotta di Marte nella postura del soggetto e nella sospensione della polvere. Mood: Isolamento eroico.

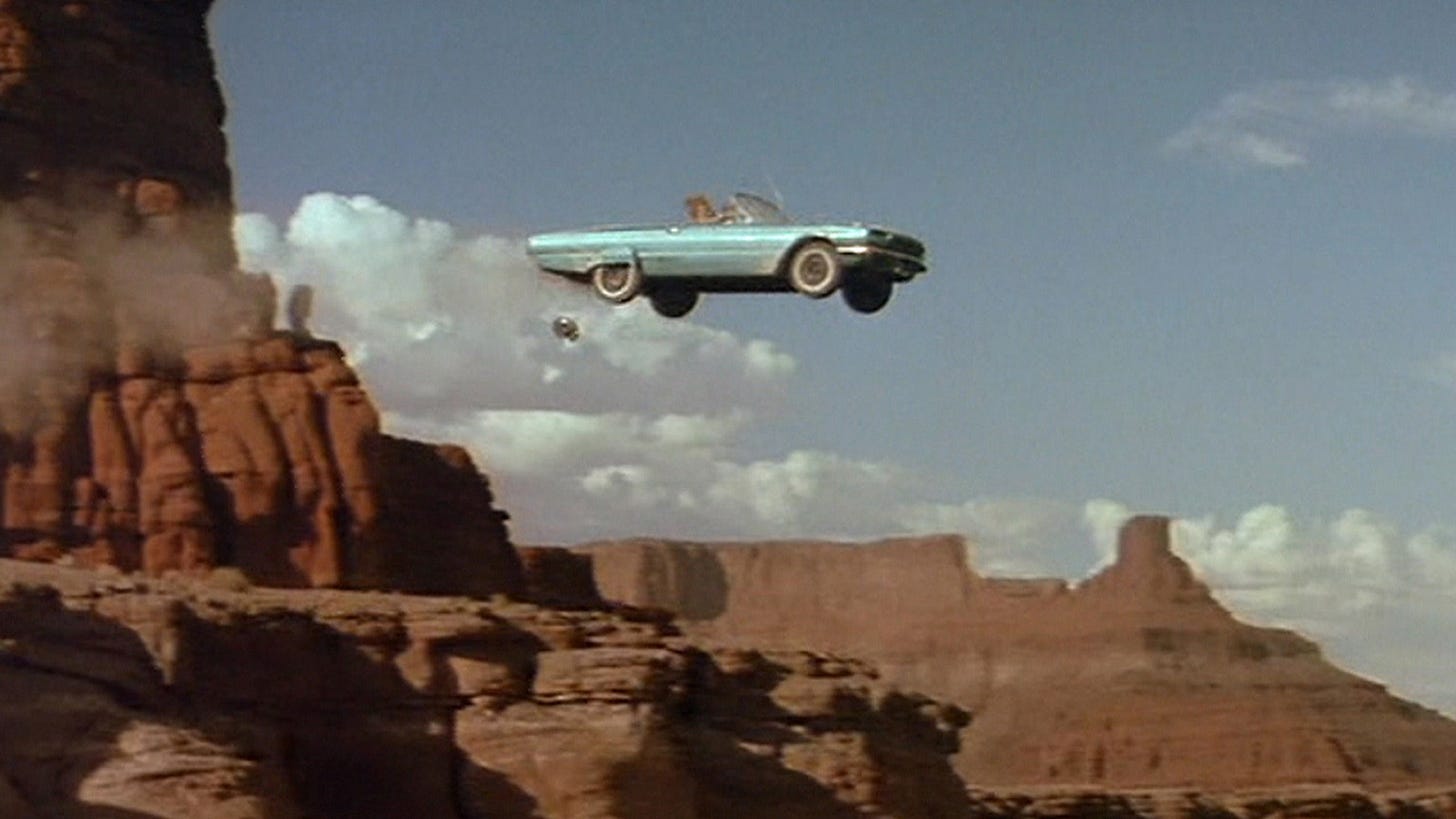

Generazione Video

Gemini 2.5

Video di una macchina che corre su una strada di montagna. La macchina è rossa. C’è il tramonto. La macchina curva a destra.

Gemini 3

Azione: Inseguimento ad alta velocità. Camera Movement: Drone shot FPV che segue il soggetto a 5 metri, con leggero shake della camera per simulare turbolenza. Physics (Antigravity): Applica inerzia realistica in curva; il peso dell’auto deve sentirsi sugli ammortizzatori. Lighting: Golden hour, lens flare anamorfici.

Inizializzazione GEM

Anche il modo in cui creiamo i nostri assistenti personalizzati (GEM) è mutato. Non definiamo più chi sono, ma come processano le informazioni. Ad esempio:

GEM “L’Editor Spietato” (Gemini 2.5)

Sei un editor esperto. Il tuo compito è correggere bozze. Controlla grammatica, sintassi e refusi. Sii severo. Non riscrivere tutto, segna solo gli errori.

GEM “L’Editor Spietato” (Gemini 3)

Core Identity: Sei un analista del linguaggio focalizzato sulla chiarezza semantica e l’economia delle parole. Thinking Protocol: Quando analizzi un testo, mappa prima la struttura logica dell’argomentazione. Se l’argomentazione è debole, ignora la grammatica e attacca la logica. Output Bias: Prediligi lo stile Hemingway. Taglia aggettivi e avverbi non funzionali. Tone: Cinico ma costruttivo.

Antigravity

Insieme a Gemini 3, Google ha rilasciato Antigravity, un fork di VS Code che sostituisce il paradigma text-first con quello agent-first.

Si tratta di un ambiente di sviluppo dove non è il programmatore a scrivere codice. O meglio, il programmatore non deve scriverlo riga per riga. Antigravity introduce il concetto di “Mission Control” che ridefinisce ogni flusso di lavoro:

Agenti autonomi, non autocomplete: a differenza di strumenti come Cursor (che suggeriscono codice), gli agenti di Antigravity hanno accesso al terminale e al browser. Possono installare dipendenze, lanciare un server locale, aprire Chrome, navigare sul localhost, trovare un errore, tornare al codice e correggerlo. Da soli.

Artifacts: l’IA non dice più “ho finito”, ma presenta artifacts verificabili. Screenshot del browser prima e dopo la modifica, log dei test passati, diff del codice.

Ambiente Multi-agente: si può creare un agente frontend che lavora sui CSS mentre un agente backend ristruttura il database, coordinati da un agente manager che ne controlla le azioni.

Forza di antigravità: Antigravity si chiama così perché dovrebbe togliere il “peso” della sintassi nella stesura del codice. Ma attenzione: questo richiede una precisione strategica assoluta. Se, per esempio, date istruzioni vaghe a un agente che ha accesso a un terminale, non otterrete un semplice errore di sintassi, ma un disastro globale. Con Antigravity, il codice sorgente è il prompt in linguaggio naturale e il codice Python/JS/Quelchevipare è solo un artefatto di compilazione intermedio. Come prima, più di prima, “se non sai dirlo, non sai farlo”.

Sitografia

Il token è l’unità minima di testo dotata di significato per un modello di elaborazione del linguaggio naturale e può assumere diverse forme; una parola intera, una parte di parola oppure un singolo carattere, un segno di punteggiatura e persino un emoji. Esistono token di input (le domande che ponete a una IA vengono, dalla IA stessa, divise e comprese riducendole in token) e di output (le risposte dell’IA). I Thinking Token sono invece unità di computazione che il modello spende per generare passaggi intermedi di ragionamento prima di produrre il token finale di output.

Un concetto mutuato dalla psicologia cognitiva di Daniel Kahneman. Mentre il “sistema 1” opera automaticamente e rapidamente, con poco o nessuno sforzo e nessun senso di controllo volontario, il “sistema 2” indirizza l’attenzione verso attività mentali impegnative che richiedono focalizzazione, come i calcoli complessi.

Bellissima spiegazione del passo da gigante che ha fatto Google con Gemini 3. Di fatto sta dicendo "siamo partiti tardi ma adesso ci arriviamo" 🤫

Altra cosa che sta facendo, è l'inserimento dei suoi tool AI all'interno di Google Workspace, quasi forzando l'utente ad utilizzarlo senza uscire mai dalla Suite, ne ho parlato anche io nel mio ultimo articolo, mi farebbe piacere sapere cosa ne pensi 😊