Meno pappagalli, più centauri

Perché l'IA non renderà più stupido chi saprà usarla bene. E qualche consiglio per un approccio corretto alla sottile arte del prompt engineering.

Scorrendo i post di questo blog, si potrebbe avere l'impressione che io sia un entusiasta acritico dell'Intelligenza Artificiale. Non è così. Il mio entusiasmo è per lo strumento e per il potenziale copernicano che possiede, ma questo non significa che non ne scorga limiti e rischi, la maggior parte dei quali risiede, come sempre, nella natura umana.

Trovo riduttivo, e anche un po’ sciocco, paragonare un miracolo tecnologico come le Intelligenze Artificiali Generative a un “pappagallo stocastico”, come suggerisce il celebre lavoro della linguista Emily M. Bender1, ma è vero che la fluidità con cui questi modelli producono testi, codici e strategie può essere facilmente scambiata dai più per pensiero autentico.

La ruggine non dorme mai

Ho letto di recente alcuni articoli (nell’ordine inverso in cui sono stati scritti, ma anche il caso vuole la sua parte) che apparentemente mettono a fuoco il problema con lucidità. Il primo, pubblicato sul blog phiand.ai e intitolato The Thinking Person’s Guide to Not AInialating Your Brain, traccia una distinzione cruciale tra il processo del pensare e il prodotto del pensiero. Il pensiero umano è un processo disordinato, faticoso, spesso frustrante. È fatto di false partenze, di connessioni improbabili, della lenta costruzione di una struttura mentale. Il testo, l'elaborato finale, è solo la punta dell'iceberg di questo sforzo cognitivo.

L'IA, ci dicono, salta a piè pari tutto questo. Non “pensa” nel senso umano del termine, ma calcola la sequenza di parole statisticamente più plausibile e ci consegna un prodotto finito, pulito, ma privo della comprensione sottostante. Usarla per “pensare” al posto nostro, quindi, sarebbe come sperare di allenarsi guardando qualcun altro fare flessioni.

L’idea trova sostegno e riscontro sulla prestigiosa MIT Technology Review, che ci avverte di un rischio specifico: il brain hijack, il dirottamento del cervello. La tendenza a delegare compiti cognitivi all'IA — un processo noto come cognitive offloading — può sensibilmente erodere le capacità mentali, esattamente come un uso eccessivo del GPS indebolisce la capacità di orientamento. Affidarsi ciecamente all'IA per strutturare argomentazioni o generare idee comporterebbe il rischio di atrofizzare i circuiti neurali dedicati al pensiero critico e alla creatività.

L'allarme sembra chiaro: il pericolo non è un'IA che diventa senziente, ma un'umanità che lo diventa assai meno.

Il decimo uomo e la prospettiva del Centauro

Proviamo a inquadrare il problema dal mio punto di vista preferito, quello del decimo uomo2. Un'analisi più attenta, come quella proposta da Alberto Romero su The Algorithmic Bridge, fa notare che i ricercatori MIT hanno osservato una diminuzione dello sforzo cognitivo, non necessariamente un peggioramento della qualità finale o un declino dell'intelligenza. Anzi, spesso i lavori prodotti con l'assistenza dell'IA erano oggettivamente migliori e completati in meno tempo.

Se confondiamo la fatica del processo col pregio del risultato, non dovremmo indossare pollici opponibili: lavorare molto e soffrendo non aggiunge alcun valore al risultato, ma suggerisce solo che forse lo si sta facendo male. Il cognitive offloading non è necessariamente negativo; è una riallocazione strategica delle risorse cognitive. Esattamente come un commercialista non diventa più stupido usando un foglio elettronico per le operazioni complesse, ma libera la propria mente per concentrarsi sulla strategia fiscale.

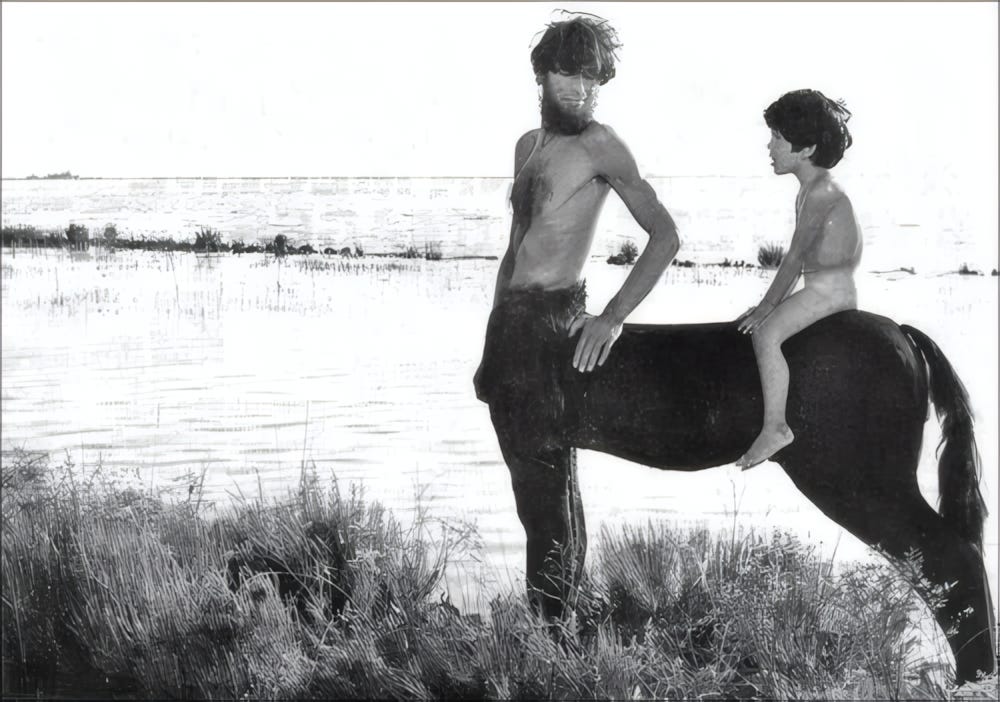

Questo ci porta a una metafora molto più potente di quella del “pappagallo”: l'intelligenza Centauro. L'idea, che risale agli albori dell'informatica e fu resa celebre nel mondo degli scacchi, descrive una simbiosi uomo-macchina. In questo modello, l'essere umano non delega il pensiero, ma la sua esecuzione tattica.

L'uomo è la mente strategica, mentre l'IA è lo strumento che esegue la manovra con velocità e precisione. Il problema, non è il rishio di atrofia cerebrale. Il problema è essere un pessimo manager delle proprie IA.

Se pensi che l’IA ti renderà più stupido, non preoccuparti: lo sei già.

Se non sai dirlo, non puoi farlo (vederlo, ascoltarlo, etc.)

Facendola più breve del dovuto, questo mi sembra il cuore del problema e quindi anche la chiave della soluzione.

È pregiudizio diffuso che la “bravura” nell'usare l'IA consista nell'imparare trucchi standardizzati o formule segrete (ma di Pulcinella) che possano obbligare gli LLM a dare risultati affidabili in qualsiasi contesto. La realtà è l'opposto.

La qualità della risposta di un'IA è quasi sempre lo specchio impietoso della qualità della domanda. E per formulare una domanda eccellente — una domanda precisa, ricca di contesto, sfumata, logicamente stringente — è necessario sapere come fare e poi aver già fatto gran parte del lavoro di deep thinking.

Solo per fare un esempio, per chiedere all'IA di generare un'analisi comparativa tra filosofia stoica buddismo zen applicata al moderno management, sono necessari:

Adeguate capacità linguistiche: per articolare la sfumatura della richiesta.

Solide basi culturali: per riconoscere risposte banali e superficiali.

Adeguate capacità logiche: per strutturare la richiesta in modo che la comparazione sia sensata.

Adeguate capacità critiche: per anticipare ogni ambiguità e guidare l'IA verso una risposta utile.

In breve, per usare l'IA come un vero strumento di potenziamento intellettuale, è necessario possedere in partenza le abilità che un uso pigro della stessa tecnologia rischia di erodere. In maniera più brutale: se sei un ciuco, non aspettarti di diventare Einstein con un abbonamento a ChatGPT. Hai comprato la Treccani, ma non sai leggere.

L'IA, nel suo utilizzo più elevato, non sostituisce il pensiero profondo, ma lo esige. Diventa un amplificatore della nostra chiarezza mentale.

Se il nostro pensiero è vago, il prompt sarà vago e il risultato inutile. Se il nostro pensiero è affilato, il prompt sarà preciso e il risultato potentissimo.

Tecniche generali di approccio alla sottile arte del prompt engineering

Come possiamo usare questi strumenti senza diventarne vittime? Il rigurgito luddista di chi le rifiuta a priori, temendo di perdere chissà quale “umanità” (o magari, solo perché non le capisce) è un approccio così cretino che non merita d’essere preso in considerazione. Proviamo a sostituirlo con qualche principio pratico.

Capitani “pensierosi”: immagina di essere su una nave. Il tuo ruolo è quello di navigatore: colui che, usando mappe, esperienza e strumenti, stabilisce la rotta, la destinazione e le tappe intermedie. Questo è il lavoro strategico, il vero deep thinking. L'IA è un eccellente timoniere, ma un timoniere senza una rotta è inutile, o peggio, pericoloso.

Un LLM non è un motore di ricerca: siamo condizionati da decenni di Google a un riflesso pavloviano: “domanda -> risposta istantanea”. Questo approccio è un errore fondamentale con gli LLM. Un motore di ricerca recupera informazioni esistenti e ne cita la fonte. Un LLM genera testo nuovo basato su pattern statistici, senza un legame obbligato con una fonte verificabile. Trattarlo come Google significa spalancare le porte a micidiali cantonate, prendendo per buono un testo che potrebbe essere solo un'invenzione ben scritta. Il pensiero profondo richiede analisi, ricerca, logica e molta pazienza; l'interazione con un LLM richiede le stesse cose e ne vuole di più.

L'interazione è un processo, non un atto unico: questo punto è strettamente correlato al precedente. L'errore più comune è considerare l'IA un oracolo a cui porre una domanda per ricevere una risposta definitiva da copiare e incollare. Questo produce solo mediocrità. L'uso più efficace di un LLM è attraverso lunghi dialoghi. La prima risposta dell'IA non è quasi mai il punto d'arrivo, ma il punto di partenza: una bozza da criticare, un'idea da raffinare, una provocazione a cui rispondere. Bisogna fornire feedback, chiedere correzioni, aggiungere vincoli, suggerire alternative. È un processo di co-creazione che richiede pazienza e piena conoscenza della direzione da intraprendere.

Affronta la pagina bianca: prima di aprire Gemini o Claude o ChatGPT o Grok, prendi un foglio di carta. Butta giù la tua mappa mentale, le parole chiave, il flusso delle idee. Combatti incertezza, imprecisione e pigrizia. Solo quando avrai una bozza di pensiero, una struttura che sia genuinamente tua, potrai usare l'IA per espanderla o rifinirla.

La sfida che l'Intelligenza Artificiale ci pone non è tecnologica, ma umanistica. Ci costringe a (ri)definire cosa significa pensare e come si fa.

Sitografia

Il termine è stato reso celebre dal paper di E. M. Bender, T. Gebru, A. McMillan-Major, e S. Shmitchell (2021), On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?.

Il concetto di “decimo uomo” invita alla critica e al pensiero divergente, specialmente in contesti decisionali. In sostanza, quando un gruppo di 10 persone concorda su una determinata visione, il “decimo uomo” ha il compito di mettere in discussione quella visione, per evitare il "pensiero di gruppo" e garantire una valutazione più completa della situazione. In Israele, questa tecnica è stata adottata dall'intelligence, in particolare dopo la Guerra dello Yom Kippur, per valutare l’affidabilità delle informazioni e prendere decisioni migliori.

Da utilizzatore professionale della AI condivido tutta l'analisi pienamente.