Motori da corsa e macchinine giocattolo

Qualche riflessione, a partire da un esperimento on-device, su Intelligenza Artificiale "di consumo" e Open Source.

Dopo aver testato Google Edge Gallery (trovate il link alla fine di questo post), m’è venuta voglia di testare le alternative disponibili, meglio se Open Source come buona parte degli LLM1 di cui disponiamo oggi.

Subisco ancora il fascino artigianale nel costruirmi da solo le tecnologie con cui lavoro e credo sarà sempre così: prepararmi “tele, inchiostri e pennelli” mi dà lo stesso piacere dell’usarli.

L’idea di partenza è stata quella di portare un LLM a funzionare localmente, on-device, su un cellulare. Ha funzionato, ma non è andata affatto come avrei sperato.

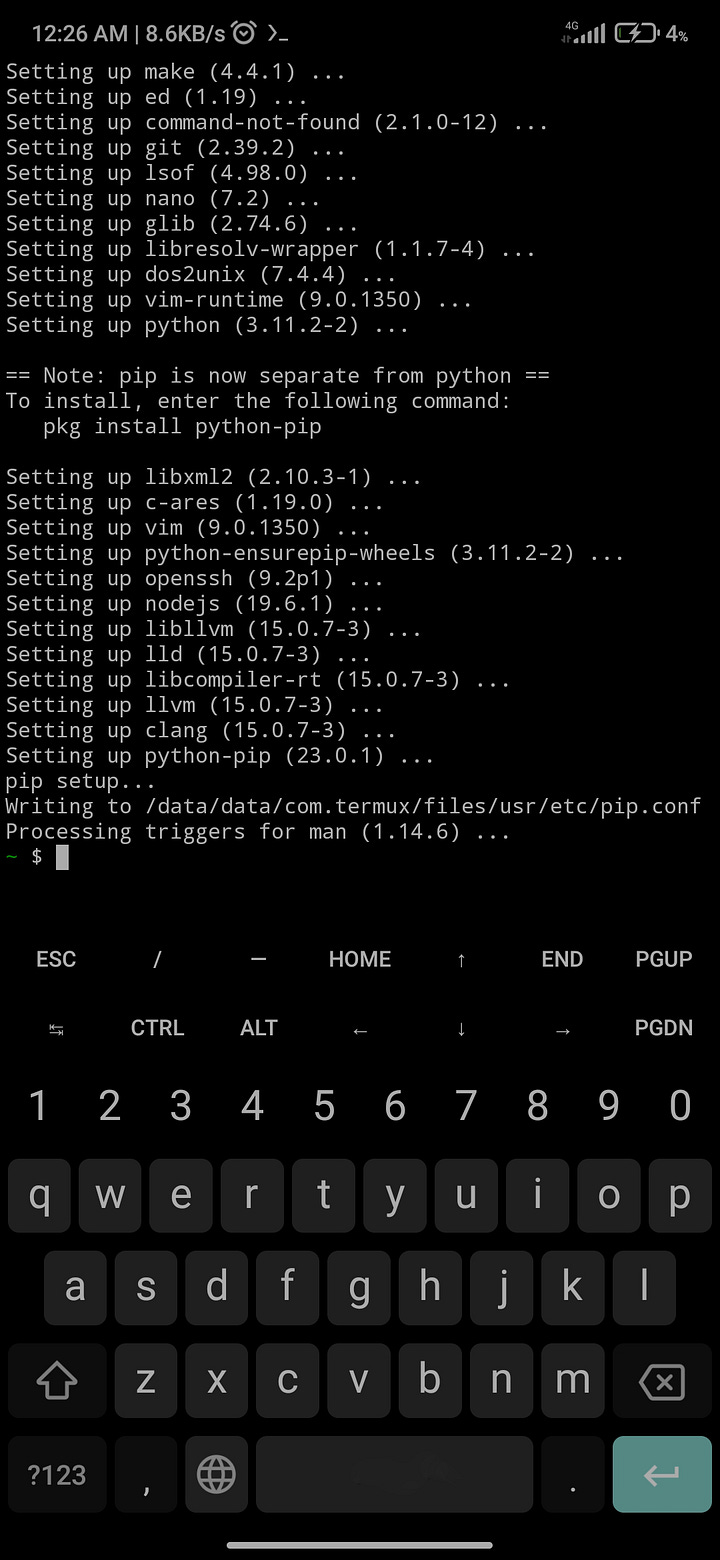

Volevo esplorare le alternative libere ai colossi cloud come ChatGPT, Claude e Gemini e sia Ollama via Termux che Maid hanno funzionato. Entrambi i progetti permettono di costruire IA personali, gratuite e offline. Maid può anche interrogare ChatGPT, Claude e Gemini via API, ma in questo caso dovete logicamente essere connessi e aver pagato per l’uso delle API (che costano comunque meno degli abbonamenti “normali”, ma di questo riparleremo).

Lo so, tra chi mi legge c’è qualcuno che si sta dicendo: «Dai, taglia corto e spiega come hai fatto!», ma no, non ve lo dirò né oggi, né qui. In fondo al post c’è una sitografia di riferimento. Se siete svegli, fate da soli e ve ne prendete la responsabilità. Non voglio sulla coscienza i vostri telefoni, né i cuccioli morti o la guerra termonucleare che potrebbero scaturire da una lettura poco attenta di certi passaggi o a un comando errato in Termux. Se per un qualsiasi motivo - che al momento non riesco a immaginare - pensate di avere bisogno di una cosa simile, ma non siete capaci di farla da soli, scrivetemi.

Comunque, per la cronaca: far partire un sistema con Ollama via Termux o Maid non richiede più di 20 minuti, tempo di scaricamento di un LLM decente compreso.

Ho testato sia Qwen2.5-Coder-1.5B-Instruct-GPTQ-Int8 che il nuovo modello tutto italiano, Minerva-7B-instruct-v1.0. E sì, vedere il terminale eseguire comandi e i modelli rispondere, è stata un'innegabile soddisfazione. Ed è stata anche la prova che la “democratizzazione” dell'IA è possibile, però questo non significa affatto che tale libertà sia alla portata di chiunque (una prima occasione di riflessione?).

Ma diciamo anche le cose come stanno… Le prestazioni sono, a essere generosi, deludenti. Lentezza, allucinazioni (Minerva mi ha consigliato di preparare per cena una insalata con 12 avocado) e un'esperienza d'uso che non è nemmeno paragonabile alla fluidità e all'eccellenza dei servizi che abbiamo già citato.

Dice: «Ma non lo sapevi già? Perché insisti?». Perché sono curioso. E poi perché mi piace comunque immaginare che un giorno avremo - o meglio, chi vorrà potrà scegliere di avere:

Privacy assoluta: qualsiasi dato sensibile – email di lavoro, documenti legali, informazioni sanitarie – potrà essere analizzato e riassunto senza mai lasciare il dispositivo personale.

Assistenti personali in emergenze: ad esempio, qualcuno che ci aiuti a riparare un guasto in una zona senza campo o ad identificare una pianta sconosciuta o il morso di un rettile per darci istruzioni di primo soccorso. E poi medici, paramedici, militari e vigili del fuoco potrebbero contare su un supporto altamente specializzato in situazioni di alta criticità in cui la rete potrebbe essere congestionata o assente. Insomma, per tutti i casi che vanno dall’incidente in passeggiata all’apocalisse zombie.

Autonomia globale: solo per fare un esempio, chi viaggia potrebbe contare su un traduttore universale e riservato che funzioni anche dove il roaming potrebbe avere costi proibitivi.

Sono cose che possiamo già quasi fare e in quel “quasi” vedo il cuore del problema. Stiamo vivendo una vera Età dell'Oro per gli LLM Open Source che sono i veri "motori" di tutto questo. Ad esempio:

Meta Llama 3: i modelli di questa famiglia, in particolare la versione da 70 miliardi di parametri, hanno dimostrato in decine di benchmark di poter competere ad armi pari con le alternative proprietarie.

Mistral AI: La startup francese è diventata un simbolo della potenza dell'innovazione europea e aperta. Il suo modello Mixtral 8x7B ha introdotto l'architettura Mixture-of-Experts2 su larga scala, offrendo un rapporto potenza/efficienza senza precedenti al momento del rilascio.

La tecnologia, insomma, c'è. Allora, perché tutta questa potenza non si traduce in prodotti di consumo altrettanto validi? Se oggi voglio usare un'IA conversazionale di alto livello, le mie opzioni sono quasi esclusivamente proprietarie. Non esiste un "Red Hat AI Assistant" o un "Canonical Chat" che possa competere con Gemini. Perché?

La risposta non credo sia tecnologica, ma strategica. Aziende come Red Hat e Canonical, pilastri storici del mondo Open Source, hanno un modello di business orientato all'impresa. Il loro obiettivo non è servire l'utente finale, ma fornire alle aziende gli strumenti per costruire le proprie soluzioni. Red Hat, per esempio, offre OpenShift AI, una piattaforma che aiuta agli sviluppatori ad addestrare, distribuire e gestire modelli di IA. Forniscono i mattoni, non il palazzo finito.

Questa scelta, perfettamente logica dal punto di vista del loro mercato, crea però un vuoto enorme, lasciando l'intero campo dell'interazione diretta con l'utente in mano a poche, gigantesche aziende che possono permettersi i costi di infrastruttura e rifinitura del prodotto.

L'attore che più si avvicina a colmare questo vuoto è HuggingFace, con il suo servizio Hugging Chat, una risorsa inestimabile che rimane, per ora, uno strumento per tecnici e appassionati.

Questo mi fa intravedere a un bivio strategico che credo definirà il prossimo decennio tecnologico. Quale strada prenderà lo sviluppo dell’hardware di consumo?

Da un lato, potremmo assistere a una corsa verso device sempre più performanti, con chip neurali specializzati, capaci di far girare localmente modelli pesanti in modo fluido ed efficiente. Forse una via possibile verso la "sovranità digitale" dell'utente, dove il dispositivo è un potente alleato autonomo. Forse…

Dall'altro, potrebbe invece delinearsi uno scenario molto più cinico. Le aziende che basano il loro profitto su servizi cloud e abbonamenti avrebbero tutto l'interesse a produrre device volutamente meno performanti di quanto sarebbe possibile. Abbastanza potenti da essere ottimi "terminali" per i loro servizi, ma non abbastanza da garantire una vera autonomia. Un futuro di utenti eternamente connessi, dipendenti da “intelligenze” più o meno centralizzate.

La vera domanda non è se l'Open Source riuscirà a creare un prodotto finale competitivo (lo abbiamo già), ma se noi avremo ancora hardware libero e sufficientemente potente per poterlo eseguire autonomamente.

Linux e l’Open Source hanno cambiato il mondo, molto più di quanto non abbiano fatto mele e finestre. E lo ha cambiato ad ogni immaginabile livello: dalle aree più povere del pianeta dove è stato possibile studiare informatica su hardware obsoleto, alla ricerca scientifica e alle applicazioni militari e d’intelligence. Se abbiamo Android e se Android è ancora (un po’) libero è perché esistono Linux e l’Open Source.

Ho l’impressione che i confini di questi territori di libertà si vadano un po’ contraendo. Fino a poco tempo fa, avevo una scelta tra strumenti Open Source e proprietari e quasi sempre quelli Open Source erano meglio. Oggi la scelta, nell’ambito dell’IA “di consumo” non c’è.

Speriamo sia solo questione di tempo.

Questo è il post di qualche giorno fa sul sistema Google per fare girare LLM Open Source su Android (e presto iOS).

Sitografia minima di riferimento

Maid (Mobile Artificial Intelligence Distribution) su GitHub

Running LLaMA-3.2 on Android: A Step-by-Step Guide using Ollama

Un Large Language Model (LLM) è una tecnologia d’Intelligenza Artificiale avanzata incentrata sulla comprensione e sull'analisi del testo. Risulta più preciso dei tradizionali algoritmi di machine learning, perché è capace di cogliere le complessità del linguaggio naturale.

L'architettura Mixture-of-Experts (MoE) utilizza diverse sotto-reti neurali (gli "esperti"), ciascuna specializzata su compiti o dati differenti. Un meccanismo di gating instrada ogni richiesta all'esperto più adatto, rendendo il modello molto più efficiente perché attiva solo una piccola parte dei suoi parametri totali per ogni inferenza.